GlusterFS je bezplatné a open source řešení pro ukládání souborů a objektů, které lze používat na fyzických, virtuálních a cloudových serverech v síti. Hlavní výhodou GlusterFS je, že můžeme škálovat nebo škálovat úložiště až na několik petabajtů bez jakýchkoli prostojů, poskytuje také redundanci a vysokou dostupnost úložiště.

Kde použít GluserFS…?

Úložiště založené na GllusterFS lze použít na fyzických, virtuálních a cloudových serverech přes síť.

Může být také použit ve firmách, kde dříve poskytovaly multimediální nebo jiný obsah uživatelům internetu a musely pracovat se stovkami terabajtů souborů.

GlusterFS lze také použít jako objektové úložiště v privátním a veřejném cloudu.

Odlišná terminologie použitá v úložišti GlusterFS:

- Důvěryhodný fond úložiště :Je to skupina více serverů, které si navzájem důvěřují a tvoří cluster úložiště.

- Uzel :Uzel je server úložiště, který se účastní důvěryhodného fondu úložiště

- Cihla :Kostkou je souborový systém XFS (512 bajtů inodů) založený na LVM připojený ke složce nebo adresáři.

- Hlasitost :Svazek je systém souborů, který je prezentován nebo sdílen klientům přes síť. Svazek lze připojit pomocí metod glusterfs, nfs a smbs.

Různé typy svazků, které lze konfigurovat pomocí GlusterFS:

- Distribuce svazků :Je to výchozí svazek, který se vytvoří, když není při vytváření svazku zadána žádná možnost. V tomto typu svazku budou soubory distribuovány přes cihly pomocí elastického hashového algoritmu

- Replikovat svazky :Jak název napovídá u tohoto typu svazku se soubory budou replikovat nebo zrcadlit napříč kostkami , Jinými slovy soubor, který je napsán v jedné kostce, bude také replikován do dalších kostek.

- pruhované svazky: V tomto typu svazku jsou větší soubory rozřezány nebo rozděleny na kusy a poté rozmístěny po kostkách.

- Distribuce replikovaných svazků :Jak název napovídá v typu svazku, soubory budou nejprve rozděleny mezi bloky a poté budou replikovány do různých bloků.

I když lze vyzkoušet i jinou kombinaci k vytvoření různých svazků, jako je například pruhovaný-replikovaný.

V tomto článku ukážu, jak nastavit úložiště GlusterFS na RHEL 7.xa CentOS 7.x. V mém případě beru čtyři servery RHEL 7 / CentOS 7 s minimální instalací a za předpokladu, že je k těmto serverům připojen další disk pro nastavení glustesfs.

- server1.example.com (192.168.43.10)

- server2.example.co m (192.168.43.20)

- server3.example.com (192.168.43.30)

- server4.example.com (192.168.43.40)

V případě, že máte svůj vlastní DNS server, přidejte následující řádky do souboru /etc/hosts.

192.168.43.10 server1.example.com server1192.168.43.20 server2.example.com server2192.168.43.30 server3.example.com server3192.168.43.40 server4.example>comNainstalujte serverové balíčky Glusterfs na všechny servery.

Balíčky Glusterfs nejsou zahrnuty ve výchozích úložištích centos a RHEL, takže nastavíme gluster repo a EPEL repo. Spusťte následující příkazy jeden po druhém na všech 4 serverech.

~]# yum nainstalovat wget~]# yum nainstalovat centos-release-gluster -y~]#yum nainstalovat epel-release -y~]# yum nainstalovat glusterfs-server -ySpusťte a povolte službu GlusterFS na všech čtyřech serverech.

~]# systemctl spustí glusterd~]# systemctl povolí glusterdPovolte porty ve bráně firewall, aby servery mohly komunikovat a vytvářet cluster úložiště (důvěryhodný fond). Spusťte níže uvedené příkazy na všech 4 serverech.

~]# firewall-cmd --zone=public --add-port=24007-24008/tcp --permanent~]# firewall-cmd --zone=public --add-port=24009/tcp -- permanent~]# firewall-cmd --zone=public --add-service=nfs --add-service=samba --add-service=samba-client --permanent~]# firewall-cmd --zone=public - -add-port=111/tcp --add-port=139/tcp --add-port=445/tcp --add-port=965/tcp --add-port=2049/tcp --add-port=38465-38469/tcp --add-port=631/tcp --add-port=111/udp --add-port=963/udp --add-port=49152-49251/tcp --permanent~]# firewall -cmd --reloadNastavení distribuce hlasitosti:

Chystám se vytvořit důvěryhodný úložný fond, který se skládá ze serveru 1 a serveru 2 a na tom vytvořím cihly a poté vytvořím distribuovaný svazek. Rovněž předpokládám, že oběma serverům je přidělen nezpracovaný disk o velikosti 16 GB (/dev/sdb).

Spusťte níže uvedený příkaz z konzoly serveru 1 a vytvořte důvěryhodný úložný fond se serverem 2.

[[email protected] ~]# gluster peer probe server2.example.compeer probe:success.[[email protected] ~]#Stav peeru můžeme zkontrolovat pomocí níže uvedeného příkazu:

[[email protected] ~]# status peer skupinyPočet vrstevníků:1Název hostitele:server2.example.comUuid:9ef0eff2-3d96-4b30-8cf7-708c15b9c9d0State:Partner v clusteru (připojeno)[##email /před>Vytvořit Brick na serveru 1

Abychom vytvořili cihlu, musíme nejprve nastavit logické svazky věcí na surovém disku (/dev/sdb).

Spusťte následující příkazy na serveru 1

[[email protected] ~]# pvcreate /dev/sdb /dev/vg_bricks/dist_brick1 /bricks/dist_brick1 xfs rw,noatime,inode64,nouuid 1 2[[email protected] ~]# vgcreate vg_bricks /dev [[email protected] ~]# lvcreate -L 14G -T vg_bricks/brickpool1Ve výše uvedeném příkazu brickpool1 je název tenkého fondu.

Nyní vytvořte logický svazek o velikosti 3 GB

[[email protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool1 -n dist_brick1Nyní naformátujte logický svazek pomocí systému souborů xfs

[[email protected] ~]# mkfs.xfs -i size=512 /dev/vg_bricks/dist_brick1[[email protected] ~]# mkdir -p /bricks/dist_brick1Připevněte kostku pomocí příkazu mount

[[email protected] ~]# montáž /dev/vg_bricks/dist_brick1 /bricks/dist_brick1/Chcete-li jej trvale připojit, přidejte následující řádek do /etc/fsatb

/dev/vg_bricks/dist_brick1 /bricks/dist_brick1 xfs rw,noatime,inode64,nouuid 1 2vytvořte adresář s cihlou pod bodem připojení

[[email protected] ~]# mkdir /bricks/dist_brick1/brickPodobně proveďte následující sadu příkazů na serveru 2

[[e-mail chráněný] ~]# pvcreate /dev/sdb; vgcreate vg_bricks /dev/sdb[[e-mail protected] ~]# lvcreate -L 14G -T vg_bricks/brickpool2[[e-mail protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool2 -n dist_brick2] [ ~[email protected] # mkfs.xfs -i size=512 /dev/vg_bricks/dist_brick2[[e-mail chráněný] ~]# mkdir -p /bricks/dist_brick2[[e-mail protected] ~]# mount /dev/vg_bricks/dist_brick2 /bricks/d [[email protected] ~]# mkdir /bricks/dist_brick2/brickVytvořte distribuovaný svazek pomocí níže uvedeného příkazu gluster :

[[email protected] ~]# svazek clusteru vytvořit distvol server1.example.com:/bricks/dist_brick1/cihla server2.example.com:/cihly/dist_brick2/cihla[[email protected] ~ Začátek # svazku clusteru distvolume start:distvol:success[[email protected] ~]#Ověřte stav svazku pomocí následujícího příkazu:

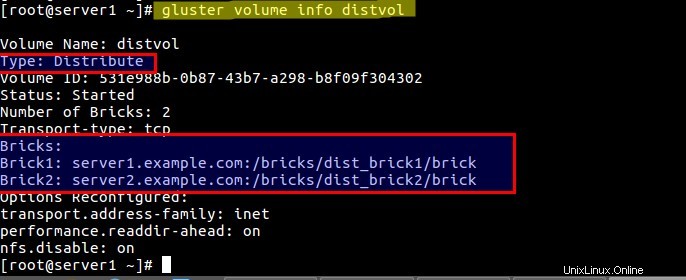

[[email protected] ~]# gluster volume info distvol

Připojit distribuovaný svazek na klienta:

Před montáží svazku pomocí glusterfs se nejprve musíme ujistit, že je na klientovi nainstalován balíček glusterfs-fuse. Ujistěte se také, že jste do souboru /etc/hosts přidali položky serveru úložiště clusteru pro případ, že nemáte místní server DNS.

Přihlaste se ke klientovi a spusťte níže uvedený příkaz z konzoly pro instalaci glusterfs-fuse

[[email protected] ~]# yum install glusterfs-fuse -yVytvořte připojení pro distribuci svazku:

[[email protected] ~]# mkdir /mnt/distvolNyní připojte „distvol pomocí níže uvedeného příkazu mount:

[[email protected] ~]# mount -t glusterfs -o acl server1.example.com:/distvol /mnt/distvol/Pro trvalé připojení přidejte níže uvedený záznam do souboru /etc/fstab

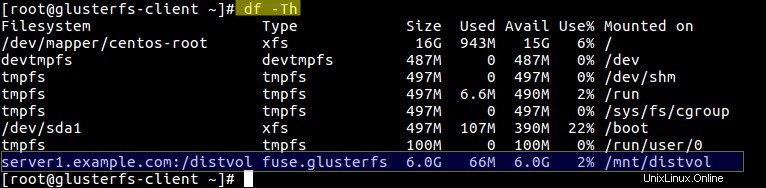

server1.example.com:/distvol /mnt/distvol glusterfs _netdev 0 0Spusťte příkaz df a ověřte stav připojení svazku.

Nyní začněte přistupovat ke svazku „distvol ”

Replikovat nastavení hlasitosti:

Pro nastavení replikovaného svazku budu používat server 3 a server 4 a předpokládám, že další disk (/dev/sdb) pro glusterfs je již přiřazen k serverům. Postupujte podle následujících kroků:

Přidejte server 3 a server 4 do důvěryhodného fondu úložiště

[[chráněno e-mailem] ~]# hromada peer probe server3.example.compeer probe:success.[[email protected] ~]# gluster peer probe server4.example.compeer probe:success.[[email protected] ~] #Vytvořte a připevněte kostku na Server 3. Spusťte níže uvedené příkazy jeden po druhém.

[[e-mail chráněný] ~]# pvcreate /dev/sdb; vgcreate vg_bricks /dev/sdb[[e-mail protected] ~]# lvcreate -L 14G -T vg_bricks/brickpool3[[e-mail protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool3 -n shadow_brick1] ~[email protected] # mkfs.xfs -i size=512 /dev/vg_bricks/shadow_brick1[[e-mail protected] ~]# mkdir -p /bricks/shadow_brick1[[e-mail protected] ~]# mount /dev/vg_bricks/shadow_brick1 /bricks/shadow_brick1 /bricks/shadow_brick [[email protected] ~]# mkdir /bricks/shadow_brick1/brickPro trvalou montáž do cihly proveďte níže uvedený záznam v souboru /etc/fstab:

/dev/vg_bricks/shadow_brick1 /bricks/shadow_brick1/ xfs rw,noatime,inode64,nouuid 1 2Podobně proveďte stejné kroky na serveru 4 pro vytvoření a montáž cihly:

[[e-mail chráněný] ~]# pvcreate /dev/sdb; vgcreate vg_bricks /dev/sdb[[e-mail protected] ~]# lvcreate -L 14G -T vg_bricks/brickpool4[[e-mail protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool4 -n shadow_brick2] ~[email protected # mkfs.xfs -i size=512 /dev/vg_bricks/shadow_brick2[[e-mail protected] ~]# mkdir -p /bricks/shadow_brick2[[e-mail protected] ~]# mount /dev/vg_bricks/shadow_brick2 /brick2/shadow_brick [[email protected] ~]# mkdir /bricks/shadow_brick2/brickPro trvalou montáž cihly proveďte záznam fstab.

Vytvořtereplikovaný svazek pomocí níže uvedeného příkazu gluster .

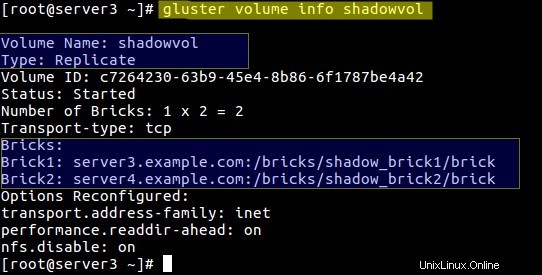

[[email protected] ~]# svazek clusteru vytvořit repliku shadowvol 2 server3.example.com:/bricks/shadow_brick1/brick server4.example.com:/bricks/shadow_brick2/brickvolume create:shadowvol:success:spusťte prosím svazek pro přístup k datům[[e-mail chráněný] ~]# start svazku skupiny shadowvolume start:shadowvol:success[[email protected] ~]#Ověřte informace o objemu pomocí níže uvedeného příkazu gluster:

[[email protected] ~]# informace o objemu clusteru shadowvol

Pokud chcete získat přístup k tomuto svazku „shadowvol ” přes nfs nastavte následující :

[[email protected] ~]# sada svazků clusteru shadowvol nfs.disable offPřipojte svazek Replicate na klienta pomocí nfs

Před montáží nejprve vytvořte přípojný bod.

[[email protected] ~]# mkdir /mnt/shadowvolPoznámka:Jedním z omezení úložiště clusteru je, že server GlusterFS podporuje pouze verzi 3 protokolu NFS.

Přidejte níže uvedený záznam do souboru „/etc/nfsmount.conf ” na obou úložných serverech (Server 3 a Server 4)

Defaultvers=3

Po provedení výše uvedeného záznamu jednou restartujte oba servery. Použijte níže uvedený příkaz mount pro svazek „shadowvol ”

[[e-mail chráněný] ~]# připojení -t nfs -o vers=3 server4.example.com:/shadowvol /mnt/shadowvol/Pro trvalé připojení přidejte následující položku do souboru /etc/fstab

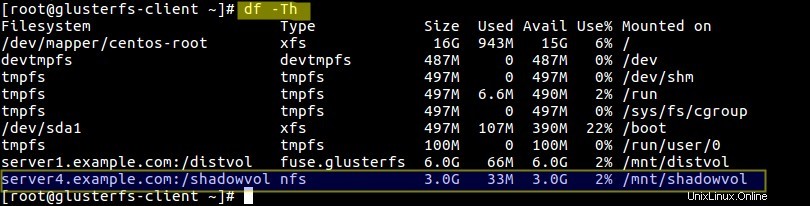

server4.example.com:/shadowvol /mnt/shadowvol/ nfs vers=3 0 0Ověřte velikost a stav připojení svazku:

[[e-mail chráněn] ~]# df -Th

Nastavení distribuce-replikace svazku:

Pro nastavení svazku Distribute-Replicate budu používat jednu cihlu z každého serveru a vytvoří svazek. Vytvořím logický svazek ze stávajícího tenkého fondu na příslušných serverech.

Vytvořte kostku na všech 4 serverech pomocí příkazů níže

Server 1

[[email protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool1 -n prod_brick1[[e-mail protected] ~]# mkfs.xfs -i size=512 /dev/vg_bricks/prod_brick1[[email protected] ~]# mkdir -p /bricks/prod_brick1[[e-mail chráněný] ~]# mount /dev/vg_bricks/prod_brick1 /bricks/prod_brick1/[[email protected] ~]# mkdir /bricks/prod_brick1/brickServer 2

[[email protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool2 -n prod_brick2[[e-mail protected] ~]# mkfs.xfs -i size=512 /dev/vg_bricks/prod_brick2[[email protected] ~]# mkdir -p /bricks/prod_brick2[[e-mail chráněný] ~]# mount /dev/vg_bricks/prod_brick2 /bricks/prod_brick2/[[email protected] ~]# mkdir /bricks/prod_brick2/brickServer 3

[[email protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool3 -n prod_brick3[[e-mail protected] ~]# mkfs.xfs -i size=512 /dev/vg_bricks/prod_brick3[[email protected] ~]# mkdir -p /bricks/prod_brick3[[email protected] ~]# mount /dev/vg_bricks/prod_brick3 /bricks/prod_brick3/[[email protected] ~]# mkdir /bricks/prod_brick3/brickServer 4

[[email protected] ~]# lvcreate -V 3G -T vg_bricks/brickpool4 -n prod_brick4[[e-mail protected] ~]# mkfs.xfs -i size=512 /dev/vg_bricks/prod_brick4[[email protected] ~]# mkdir -p /bricks/prod_brick4[[email protected] ~]# mount /dev/vg_bricks/prod_brick4 /bricks/prod_brick4/[[email protected] ~]# mkdir /bricks/prod_brick4/brickNyní vytvořte svazek s názvem „dist-rep-vol ” pomocí níže uvedeného příkazu gluster:

[[email protected] ~]# svazek clusteru vytvořit repliku 2 dist-rep-vol server1.example.com:/cihly/prod_cihla1/cihla server2.example.com:/cihly/prod_cihla2/cihla server3.example.com :/bricks/prod_brick3/brick server4.example.com:/bricks/prod_brick4/brick force[[e-mail chráněný] ~]# startovní svazek skupiny dist-rep-volOvěřte informace o hlasitosti pomocí níže uvedeného příkazu:

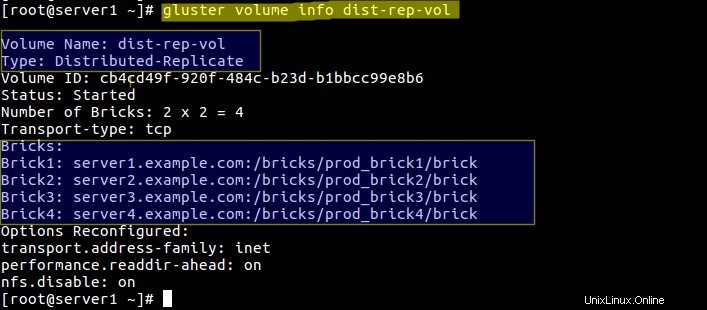

[[email protected] ~]# informace o svazku skupiny dist-rep-vol

V tomto svazku budou nejprve soubory distribuovány na libovolné dvě kostky a poté budou soubory replikovány do zbývajících dvou kostek.

Nyní připojte tento svazek na klientský počítač pomocí gluster

nejprve vytvořte bod připojení pro tento svazek:

[[email protected] ~]# mkdir /mnt/dist-rep-vol[[email protected] ~]# mount.glusterfs server1.example.com:/dist-rep-vol /mnt/dist-rep- vol/Přidejte níže záznam do fstab pro trvalý záznam

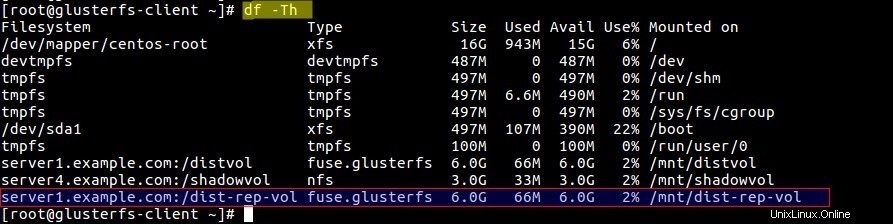

server1.example.com:/dist-rep-vol /mnt/dist-rep-vol/ glusterfs _netdev 0 0Ověřte velikost a objem pomocí příkazu df :

A je to. Doufám, že se vám kroky konfigurace úložiště clusteru líbily.

Jak nainstalovat a nakonfigurovat oVirt 4.0 na CentOS 7 / RHEL 7 Jak nainstalovat a nakonfigurovat Jenkins na CentOS 7 a RHEL 7Cent OS