Jako správce systému je nezbytné zajistit vysokou dostupnost na všech možných úrovních v architektuře a designu systému a prostředí SAP se neliší. V tomto článku pojednávám o tom, jak využít Red Hat Enterprise Linux (RHEL) Pacemaker pro vysokou dostupnost (HA) SAP NetWeaver Advanced Business Application Programming (ABAP) SAP Central Service (ASCS)/Enqueue Replication Server (ERS).

[ Také by se vám mohlo líbit: Stručný průvodce pro správce systému Ansible pro Linux ]

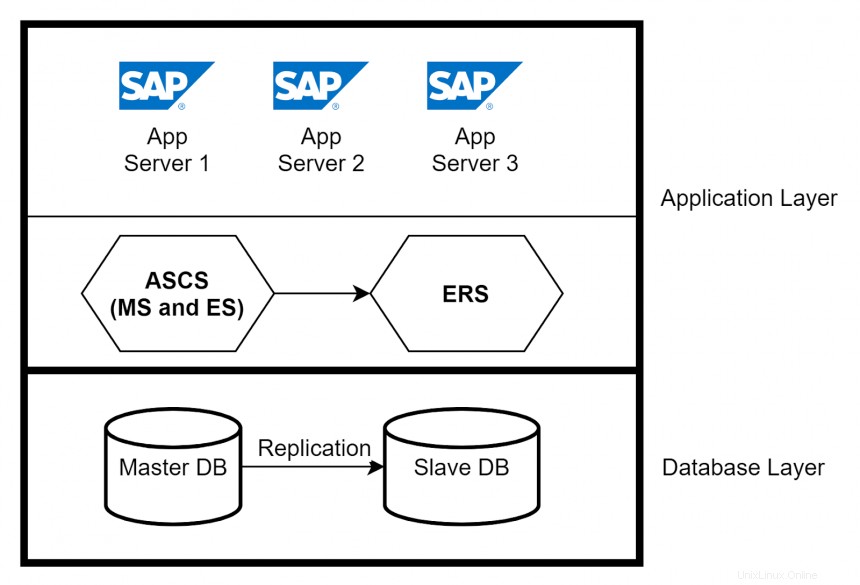

SAP má třívrstvou architekturu:

- Vrstva prezentace —Představuje GUI pro interakci s aplikací SAP

- Aplikační vrstva —Obsahuje jeden nebo více aplikačních serverů a server zpráv

- Databázová vrstva —Obsahuje databázi se všemi daty souvisejícími se SAP (například Oracle)

V tomto článku je hlavní důraz kladen na aplikační vrstvu. Instance aplikačního serveru poskytují skutečné funkce zpracování dat systému SAP. Na základě systémových požadavků je vytvořeno více aplikačních serverů, které zvládají zátěž systému SAP. Další hlavní komponentou v aplikační vrstvě je ABAP SAP Central Service (ASCS). Centrální služby se skládají ze dvou hlavních součástí – Message Server (MS) a Enqueue Server (ES). Message Server funguje jako komunikační kanál mezi všemi aplikačními servery a zajišťuje distribuci zátěže. Server Enqueue řídí mechanismus zámku.

Vysoká dostupnost v aplikačních a databázových vrstvách

Vysokou dostupnost pro aplikační servery můžete implementovat pomocí nástroje pro vyrovnávání zatížení a tím, že požadavky od uživatelů zpracovává více aplikačních serverů. Pokud dojde k selhání aplikačního serveru, budou ovlivněni pouze uživatelé připojení k tomuto serveru. Izolujte selhání odstraněním aplikačního serveru z nástroje pro vyrovnávání zatížení. Pro vysokou dostupnost ASCS použijte k replikaci záznamů tabulky zámků Enqueue Replication Server (ERS). V databázové vrstvě můžete nastavit replikaci nativní databáze mezi primárními a sekundárními databázemi, abyste zajistili vysokou dostupnost.

Úvod do RHEL High Availability with Pacemaker

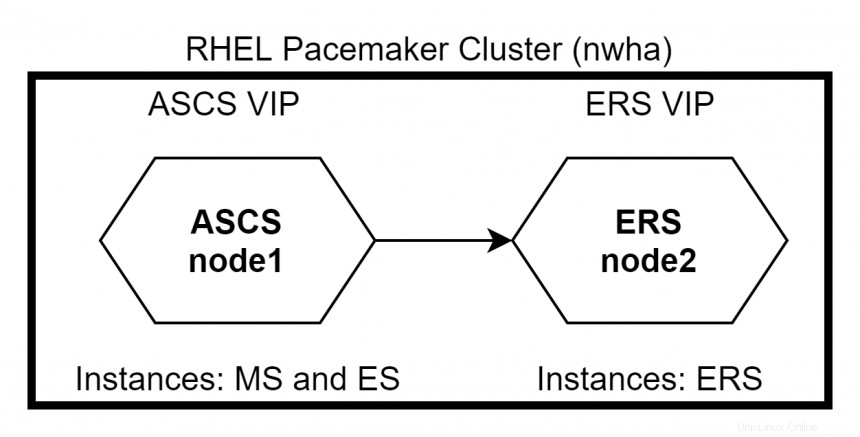

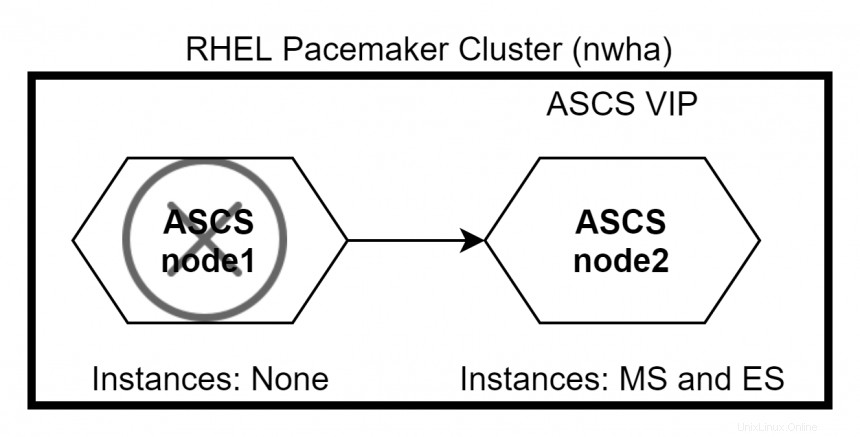

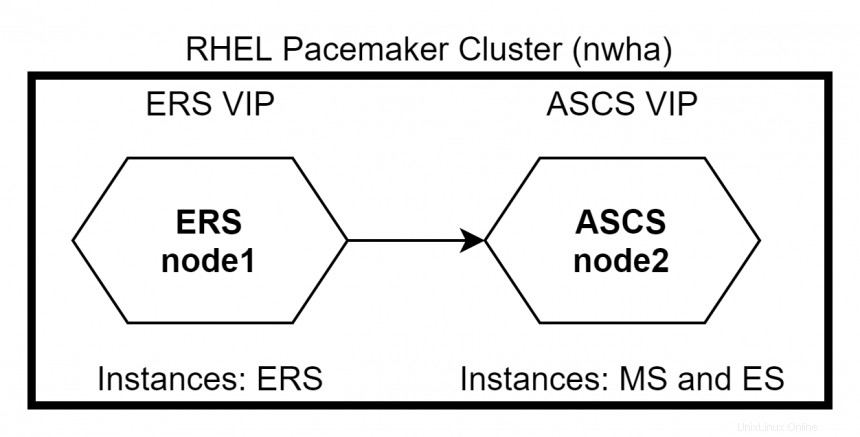

RHEL High Availability umožňuje službám bezproblémové převzetí služeb při selhání z jednoho uzlu do druhého v rámci clusteru, aniž by došlo k jakémukoli přerušení služby. ASCS a ERS lze integrovat do clusteru kardiostimulátorů RHEL. V případě selhání uzlu ASCS se klastrové balíčky přesunou do uzlu ERS, kde budou instance MS a ES nadále běžet, aniž by došlo k zastavení systému. V případě selhání uzlu ERS to neovlivní systém, protože MS a ES budou na uzlu ASCS nadále běžet. V tomto případě instance ERS nepoběží na uzlu ASCS, protože instance ES a ERS nemusí běžet na stejném uzlu.

Konfigurace kardiostimulátoru RHEL

Existují dva způsoby konfigurace uzlů ASCS a ERS v clusteru RHEL Pacemaker – Primární/Sekundární a Samostatné . Primární/Sekundární přístup je podporován ve všech menších vydáních RHEL 7. Samostatný přístup je podporován v RHEL 7.5 a novějších. RHEL doporučuje použití samostatného přístupu pro všechna nová nasazení.

Konfigurace clusteru

Obecné kroky konfigurace clusteru zahrnují:

- Nainstalujte balíčky Pacemaker na oba uzly clusteru.

# yum -y install pcs pacemaker - Vytvořte HACLUSTER ID uživatele s.

Chcete-li použít# passwd haclusterpcspro konfiguraci clusteru a komunikaci mezi uzly musíte pro každý uzel nastavit heslo pro ID uživatele hacluster , což jepcsadministrační účet. Doporučuje se zadat heslo pro uživatele hacluster být stejný na každém uzlu. - Povolte a spusťte

pcsslužby.# systemctl enable pcsd.service; systemctl start pcsd.service - Ověřte

pcss hacluster uživatel

Ověřtepcsuživatel hacluster pro každý uzel v clusteru. Následující příkaz ověřuje uživatele hacluster na uzlu1 pro oba uzly ve dvouuzlovém clusteru (node1.example.com a node2.example.com).# pcs cluster auth node1.example.com node2.example.com Username: hacluster Password: node1.example.com: Authorized node2.example.com: Authorized - Vytvořte cluster.

Cluster nwha je vytvořen pomocí node1 a node2:# pcs cluster setup --name nwha node1 node2 - Spusťte cluster.

# pcs cluster start --all - Povolte automatické spouštění clusteru po restartu.

# pcs cluster enable --all

Vytváření prostředků pro instance ASCS a ERS

Nyní, když je cluster nastaven, musíte přidat prostředky pro uzly ASCS a ERS. Mezi obecné kroky patří:

- Nainstalujte

resource-agents-sapna všech uzlech clusteru.# yum install resource-agents-sap - Nakonfigurujte sdílený souborový systém jako prostředky spravované clusterem.

Sdílený souborový systém, jako je/sapmnt,/usr/sap/trans,/usr/sap/jsou přidány jako prostředky automaticky připojené ke clusteru pomocí příkazu:SYS # pcs resource create <resource-name> Filesystem device=’<path-of-filesystem>’ directory=’<directory-name>’ fstype=’<type-of-fs>’

Příklad:# pcs resource create sid_fs_sapmnt Filesystem device='nfs_server:/export/sapmnt' directory='/sapmnt' fstype='nfs' - Nakonfigurujte skupinu prostředků pro ASCS.

Pro uzel ASCS jsou tři požadované skupiny prostředků následující (za předpokladu, že ID instance ASCS je 00):- Virtuální IP adresa pro ASCS

- Souborový systém ASCS (například

/usr/sap/<SID>/ASCS00) - Instance profilu ASCS (například

/sapmnt/<SID>/profile/<SID>_ASCS00_<hostname>)

- Nakonfigurujte skupinu prostředků pro ERS.

Pro uzel ERS jsou tři požadované skupiny prostředků následující (za předpokladu ID instance ERS v 30):- Virtuální IP adresa pro ERS

- Souborový systém ERS (například

/usr/sap/<SID>/ERS30) - Instance profilu ERS (například

/sapmnt/<SID>/profile/<SID>_ERS30_<hostname>)

- Vytvořte omezení.

Nastavte omezení ASCS a ERS skupiny prostředků pro následující:- Omezit spuštění obou skupin prostředků na stejném uzlu

- Umožněte spuštění ASCS na uzlu, kde běžel ERS v případě převzetí služeb při selhání

- Dodržujte pořadí pořadí spuštění/zastavení

- Zajistěte, aby se cluster spustil až po připojení požadovaných souborových systémů

Cluster Failover Testing

Za předpokladu, že ASCS běží na uzlu1 a ERS běží na node2 zpočátku. Pokud uzel1 klesá, ASCS i ERS se posunou na node2 . Kvůli definovanému omezení nepoběží ERS na node2 .

Když uzel1 se vrátí, ERS se přesune na node1 zatímco ASCS zůstává na uzlu2 . Použijte příkaz #pcs status zkontrolovat stav clusteru.

[ Bezplatný kurz pro vás:Technický přehled virtualizace a migrace infrastruktury. ]

Zabalit

RHEL Pacemaker je skvělý nástroj pro dosažení vysoce dostupného clusteru pro SAP. Můžete také provádět oplocení konfigurací STONITH, abyste zajistili integritu dat a zabránili využití zdrojů vadným uzlem v clusteru.

Pro všechny nadšence do automatizace můžete Ansible využít k ovládání vašeho clusteru Pacemaker pomocí modulu Ansible pacemaker_cluster. Stejně jako chráníte své systémy, postarejte se o sebe a zůstaňte v bezpečí.