Cef je bezplatné a open source distribuované úložiště řešení, jehož prostřednictvím můžeme snadno poskytovat a spravovat úložiště bloků, úložiště objektů a úložiště souborů. Řešení Ceph storage lze použít v tradiční IT infrastruktuře pro poskytování centralizovaného úložiště, kromě toho se používá také v privátním cloudu (OpenStack &Cloudstack ). V Red Hat OpenStack se Ceph používá jako backend škváry.

V tomto článku si ukážeme, jak nainstalovat a nakonfigurovat Ceph Cluster(Mimic) na serverech CentOS 7.

V Ceph Cluster jsou následující hlavní součásti:

- Monitory (ceph-mon) :Jak název napovídá, uzly ceph monitoru sledují stav clusteru, mapu OSD a mapu Crush

- OSD ( Ceph-osd) :Toto jsou uzly, které jsou součástí clusteru a poskytují funkce pro ukládání dat, replikaci dat a obnovu. OSD také poskytuje informace pro monitorování uzlů.

- MDS (Ceph-mds) :Je to server metadat ceph a ukládá metadata systémů souborů ceph, jako je blokové úložiště.

- Uzel nasazení Ceph :Používá se k nasazení clusteru Ceph, nazývá se také uzel Ceph-admin nebo Ceph-utility.

Podrobnosti nastavení My Lab:

- Uzel nasazení Ceph :(Minimální CentOS 7, RAM:4 GB, vCPU:2, IP:192.168.1.30, název hostitele:ceph-controller)

- OSD nebo Ceph Compute 1 :(Minimální CentOS 7, RAM:10 GB, vCPU:4, IP:192.168.1.31, Název hostitele:ceph-compute01)

- OSD nebo Ceph Compute 2 :(Minimální CentOS 7, RAM:10 GB, vCPU:4, IP:192.168.1.32, Název hostitele:ceph-compute02)

- Monitor Ceph :(Minimální CentOS 7, RAM:10 GB, vCPU:4, IP:192.168.1.33, název hostitele:ceph-monitor)

Poznámka: Ve všech uzlech máme připojeny dvě nic (eth0 ð1), na eth0 je přiřazena IP z VLAN 192.168.1.0/24 . Na eth1 IP z VLAN je přiděleno 192.168.122.0/24 a bude poskytovat přístup k internetu.

Pojďme se vrhnout na kroky instalace a konfigurace:

Krok:1) Aktualizujte soubor /etc/hosts, NTP, vytvořte uživatele a zakažte SELinux na všech uzlech

Přidejte následující řádky do souboru /etc/hosts všech uzlů, aby bylo možné k těmto uzlům přistupovat také prostřednictvím jejich názvu hostitele.

192.168.1.30 ceph-controller192.168.1.31 ceph-compute01192.168.1.32 ceph-compute02192.168.1.33 ceph-monitor

Nakonfigurujte všechny uzly Ceph pomocí serveru NTP tak, aby všechny uzly měly stejný čas a nedocházelo k žádnému posunu v čase,

~]# yum nainstalovat ntp ntpdate ntp-doc -y~]# ntpdate europe.pool.ntp.org~]# systemctl spustit ntpd~]# systemctl povolit ntpd

Vytvořte uživatele s názvem „cephadm ” na všech uzlech a tohoto uživatele budeme používat pro nasazení a konfiguraci ceph

~]# userradd cephadm &&echo "[email protected]#" | passwd --stdin cephadm

Nyní přidělte administrátorská práva uživateli cephadm pomocí sudo, proveďte následující příkazy

~]# echo "cephadm ALL =(root) NOPASSWD:ALL" | sudo tee /etc/sudoers.d/cephadm~]# chmod 0440 /etc/sudoers.d/cephadm

Zakažte SELinux na všech uzlech pomocí příkazu sed, dokonce i oficiální stránka ceph doporučuje zakázat SELinux,

~]# sed -i --follow-symlinks 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/sysconfig/selinux

Restartujte nyní všechny uzly pomocí příkazu beneath,

~]# restartování

Krok:2 Konfigurace ověřování bez hesla od správce Ceph do všech OSD a monitorovacích uzlů

Z uzlu Ceph-admin použijeme nástroj známý jako „ceph-deploy “, přihlásí se ke každému uzlu ceph a nainstaluje balíček ceph a provede všechny požadované konfigurace. Při přístupu k uzlu Ceph nás nevyzve k zadání přihlašovacích údajů ceph uzlů, proto jsme požadovali nakonfigurovat ověřování bez hesla nebo na klíčích z uzlu ceph-admin do všech uzlů ceph.

Spusťte následující příkazy jako uživatel cephadm z uzlu Ceph-admin (ceph-controller). Nechte přístupovou frázi prázdnou.

[[email protected] ~]$ ssh-keygenGenerating public/private rsa key pair.Zadejte soubor, do kterého se má klíč uložit (/home/cephadm/.ssh/id_rsa):Vytvořen adresář '/home/cephadm/. ssh'.Zadejte přístupové heslo (prázdné pro žádné heslo):Zadejte znovu stejné přístupové heslo:Vaše identifikace byla uložena do /home/cephadm/.ssh/id_rsa.Váš veřejný klíč byl uložen do /home/cephadm/.ssh/id_rsa. pub. Otisk klíče je:93:01:16:8a:67:34:2d:04:17:20:94:ad:0a:58:4f:8a [e-mail chráněný]Obrázek náhodného obrázku klíče je:+- -[ RSA 2048]----+|o.=+*o+. || o.=o+.. ||.oo++. . ||E..o. o ||o S ||. . || || || |+-----------------+[[e-mail chráněný] ~]$

Nyní zkopírujte klíče do všech ceph uzlů pomocí příkazu ssh-copy-id

[[chráněno e-mailem] ~]$ ssh-copy-id [e-mailem chráněno][[e-mailem chráněno] ~]$ ssh-copy-id [e-mailem chráněno][[e-mailem chráněno] ~]$ ssh-copy-id [e-mail chráněn]

Doporučuje se přidat následující do souboru „~/.ssh/config“

[[email protected] ~]$ vi ~/.ssh/configHost ceph-compute01 Název hostitele ceph-compute01 Uživatel cephadmHost ceph-compute02 Název hostitele ceph-compute02 Uživatel cephadmHost ceph-monitor ceph-monitor pre mon UživatelUložte a ukončete soubor.

[e-mail chráněný] ~]$ chmod 644 ~/.ssh/config[[e-mail chráněn] ~]$Poznámka: Ve výše uvedeném příkazu nahraďte uživatelské jméno a název hostitele, který vyhovuje vašemu nastavení.

Krok:3) Nakonfigurujte pravidla brány firewall pro OSD a monitorovací uzly

V případě, že je OS firewall povolen a běží na všech ceph uzlech, musíme nakonfigurovat níže uvedená pravidla firewallu, jinak můžete tento krok přeskočit.

V uzlu Ceph-admin nakonfigurujte následující pravidla brány firewall pomocí příkazů níže,

[[e-mail chráněný] ~]$ sudo firewall-cmd --zone=public --add-port=80/tcp --permanentsuccess[[e-mail chráněný] ~]$ sudo firewall-cmd --zone=public - -add-port=2003/tcp --permanentsuccess[[e-mail chráněný] ~]$ sudo firewall-cmd --zone=public --add-port=4505-4506/tcp --permanentsuccess[[e-mail chráněný] ~]$ sudo firewall-cmd --reloadsuccess[[chráněn e-mailem] ~]$Přihlaste se do OSD nebo Ceph Compute Nodes a nakonfigurujte pravidla brány firewall pomocí příkazu firewall-cmd,

[[chráněno e-mailem] ~]$ sudo firewall-cmd --zone=public --add-port=6800-7300/tcp --permanentsuccess[[chráněno e-mailem] ~]$ sudo firewall-cmd --reloadsuccess[ [e-mail chráněný] ~]$[[e-mail chráněný] ~]$ sudo firewall-cmd --zone=public --add-port=6800-7300/tcp --permanentsuccess[[e-mail chráněný] ~]$ sudo firewall-cmd --reloadsuccess[[email protected] ~]$Přihlaste se k uzlu Ceph Monitor a spusťte příkaz firewalld pro konfiguraci pravidel brány firewall

[[e-mail chráněný] ~]$ sudo firewall-cmd --zone=public --add-port=6789/tcp --permanentsuccess[[e-mail chráněný] ~]$ sudo firewall-cmd --reloadsuccess[[e-mail chráněno] ~]$Krok:4) Nainstalujte a nakonfigurujte Ceph Cluster z uzlu Ceph Admin

Přihlaste se do svého uzlu Ceph-admin jako uživatel „cephadm“ a povolte nejnovější verzi úložiště Ceph yum. V době psaní tohoto článku je Mimic nejnovější verzí Ceph,

[[e-mail chráněný] ~]$ sudo rpm -Uvh https://download.ceph.com/rpm-mimic/el7/noarch/ceph-release-1-1.el7.noarch.rpmPovolte také úložiště EPEL,

[[email protected] ~]$ sudo yum install -y https://dl.fedoraproject.org/pub/epel/epel-release-latest-7.noarch.rpmNainstalujte obslužný program Ceph-deploy pomocí následujícího příkazu yum,

[[email protected] ~]$ sudo yum update -y &&sudo yum install ceph-deploy python2-pip -yVytvořte adresář s názvem „ceph_cluster “, tento adresář bude mít všechny konfigurace clusteru

[[email protected] ~]$ mkdir ceph_cluster[[email protected] ~]$ cd ceph_cluster/[[email protected] ceph_cluster]$Nyní vygenerujte konfiguraci clusteru spuštěním obslužného programu ceph-deploy na uzlu ceph-admin, registrujeme uzel ceph-monitor jako monitorovací uzel v clusteru ceph. Nástroj Ceph-deploy také vygeneruje „ceph.conf ” v aktuálním pracovním adresáři.

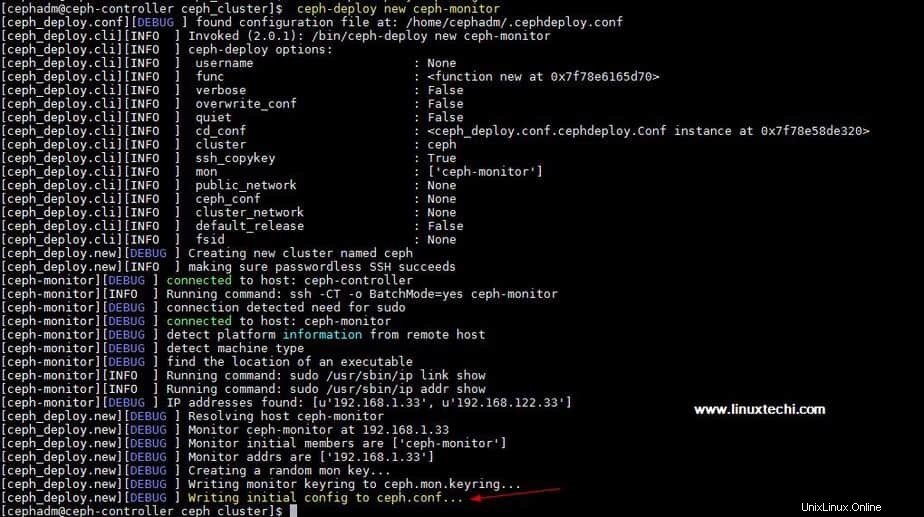

[[email protected] ceph_cluster]$ ceph-deploy nový ceph-monitorVýstup výše uvedeného příkazu by byl něco jako níže:

Aktualizujte síťovou adresu (veřejnou síť) podle globální směrnice vceph.conf soubor, Veřejná síť je síť, ve které budou uzly Ceph komunikovat mezi sebou a externí klient bude tuto síť používat také pro přístup k úložišti ceph,

[Pre> [[chráněno e-mailem] Ceph_Cluster] $ VI Ceph.Conf [Global] FSID =B1E269F0-03EA-4545-8FFD-4E0F79350900MON_INITIAL_MEMBERS =CEPHONCILIRED =CEPHEFRIFICE =CEPHIFIRET =CEPHEFRIFICE =CEPHIFICE =CEPHRIFICES =CEPHEFTICECTONITY 24

Uložte a ukončete soubor.

Nyní nainstalujte ceph na všechny uzly z uzlu ceph-admin, spusťte „instalaci ceph-deploy ”příkaz

[[email protected] ~]$ instalace ceph-deploy ceph-controller ceph-compute01 ceph-compute02 ceph-monitor

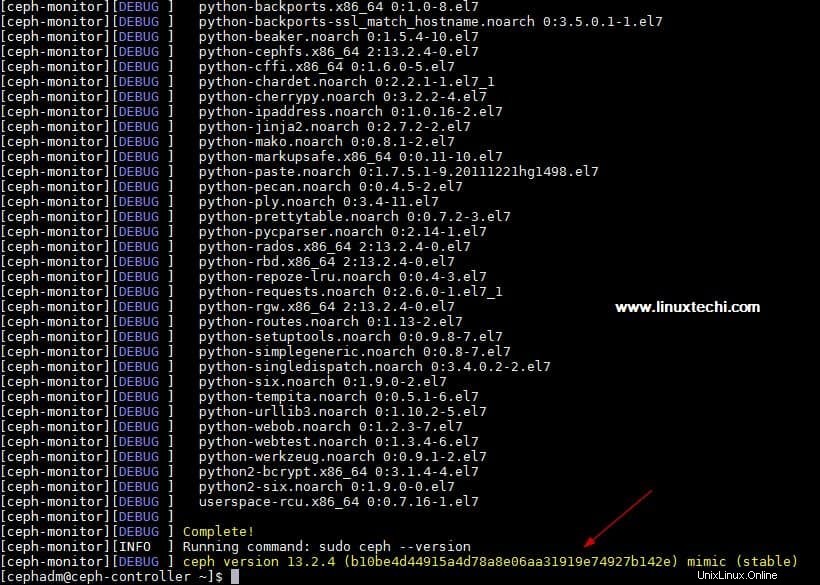

Výše uvedený příkaz nainstaluje ceph spolu s dalšími závislostmi automaticky na všechny uzly, může to nějakou dobu trvat v závislosti na rychlosti internetu na ceph uzlech.

Výstup výše uvedeného „ceph-deploy install ” výstup příkazu by byl něco jako níže:

Proveďte „ceph-deploy mon create-initial ” z uzlu ceph-admin, nasadí počáteční monitory a shromáždí klíče.

[[email protected] ~]$ cd ceph_cluster/[[email protected] ceph_cluster]$ ceph-deploy mon create-initial

Spusťte „ceph-deploy admin ” ke zkopírování konfiguračního souboru z uzlu ceph-admin do všech uzlů ceph, takže lze použít příkaz ceph cli bez zadání adresy monitoru.

[[email protected] ceph_cluster]$ správce ceph-deploy ceph-controller ceph-compute01 ceph-compute02 ceph-monitor

Nainstalujte Démon správce z uzlu Ceph-admin na Ceph Compute Nodes (OSD) pomocí následujícího příkazu

[[email protected] ceph_cluster]$ ceph-deploy mgr create ceph-compute01 ceph-compute02

Krok:5) Přidejte OSD disky do clusteru

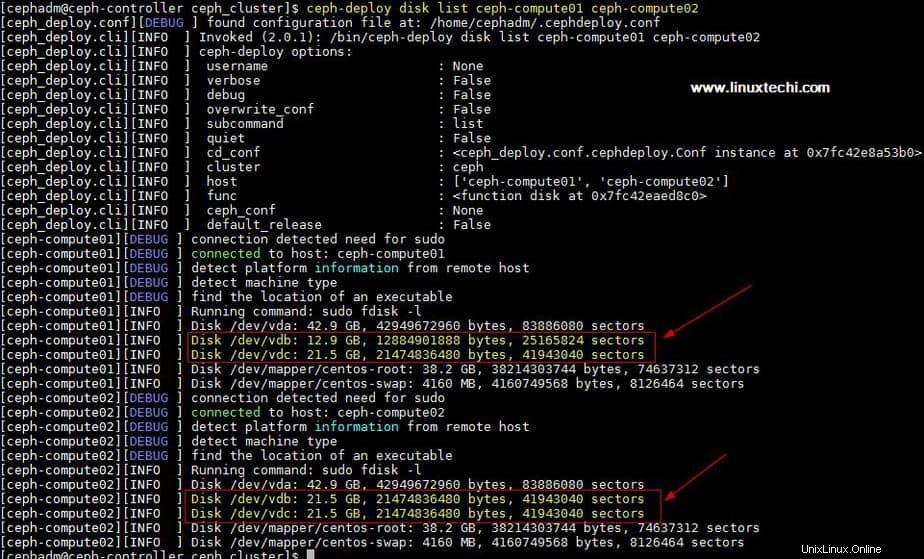

V mém nastavení jsem připojil dva disky /dev/vdb &/dev/vdc na obou výpočetních uzlech použiji tyto čtyři disky z výpočetních uzlů jako OSD disk.

Pojďme ověřit, zda nástroj ceph-deploy tyto disky vidí nebo ne. Spusťte „seznam disků ceph-deploy ” příkaz z uzlu ceph-admin,

[[email protected] ceph_cluster]$ seznam disků ceph-deploy ceph-compute01 ceph-compute02

Výstup výše uvedeného příkazu:

Poznámka: Ujistěte se, že tyto disky nejsou nikde použity a neobsahují žádná data

Chcete-li vyčistit a odstranit data z disků, použijte následující příkazy,

[[email protected] ceph_cluster]$ ceph-deploy disk zap ceph-compute01 /dev/vdb[[email protected] ceph_cluster]$ ceph-deploy disk zap ceph-compute01 /dev/vdc[[email protected] $ ceph-deploy disk zap ceph-compute02 /dev/vdb[[e-mail chráněný] ceph_cluster]$ ceph-deploy disk zap ceph-compute02 /dev/vdc

Nyní označte tyto disky jako OSD pomocí následujících příkazů

[[email protected] ceph_cluster]$ ceph-deploy osd create --data /dev/vdb ceph-compute01[[email protected] ceph_cluster]$ ceph-deploy osd create --data /dev/vdc ceph-compute01[ [email protected] ceph_cluster]$ ceph-deploy osd create --data /dev/vdb ceph-compute02[[email protected] ceph_cluster]$ ceph-deploy osd create --data /dev/vdc ceph-compute02

Krok:6) Ověřte stav clusteru Ceph

Ověřte stav svého clusteru Ceph pomocí „zdraví ceph “ a „ceph -s “, spusťte tyto příkazy z monitor node

[[chráněno e-mailem] ~]# ceph healthHEALTH_OK[[email protected] ~]#[[email protected] ~]# ceph -s cluster: id: 4f41600b-1c5a-4628-a0fc-2d8e7c091aa services po:1 démoni, quorum ceph-monitor mgr:ceph-compute01(aktivní), pohotovostní režimy:ceph-compute02 osd:4 osds:4 nahoru, 4 in data: pooly: 0 pools, 0 pgs , využití B objektů:0 : 4,0 GiB využito, 76 GiB / 80 GiB využito pgs:[[email protected] ~]#

Jak můžeme vidět ve výše uvedeném výstupu, že zdraví ceph clusteru je v pořádku a máme 4 OSD, všechny tyto OSD jsou aktivní a aktivní, kromě toho můžeme vidět, že v našem clusteru je k dispozici 80 GB místa na disku.

Tímto potvrzujeme, že jsme úspěšně nainstalovali a nakonfigurovali Ceph Cluster na systému CentOS 7. Pokud vám tyto kroky pomohou nainstalovat ceph do vašeho prostředí, podělte se o své názory a komentáře.

V nadcházejícím článku probereme, jak přiřadit úložiště bloků z clusteru Ceph klientům, a uvidíme, jak může klient přistupovat k úložišti bloků.